双链路设计:AI服务器集群的生命线

千卡GPU集群单链路架构的致命缺陷——

训练中断成本:单个 Spine 交换机故障会给企业带来巨大的小时损失

延迟敏感挑战:AllReduce 操作需要梯度同步延迟

可靠性瓶颈:传统树形拓扑有7个潜在的单点故障链路

血泪教训:一家AI公司的真实案例

2024年第三季度,一家制造商未能部署双链路,导致:

交换机端口故障导致训练中断72分钟

间接损失:因模型交付延迟而产生的合同违约金

双链路设计正是解决这一痛点的核心方案。

2.双链路叶脊架构全景分析

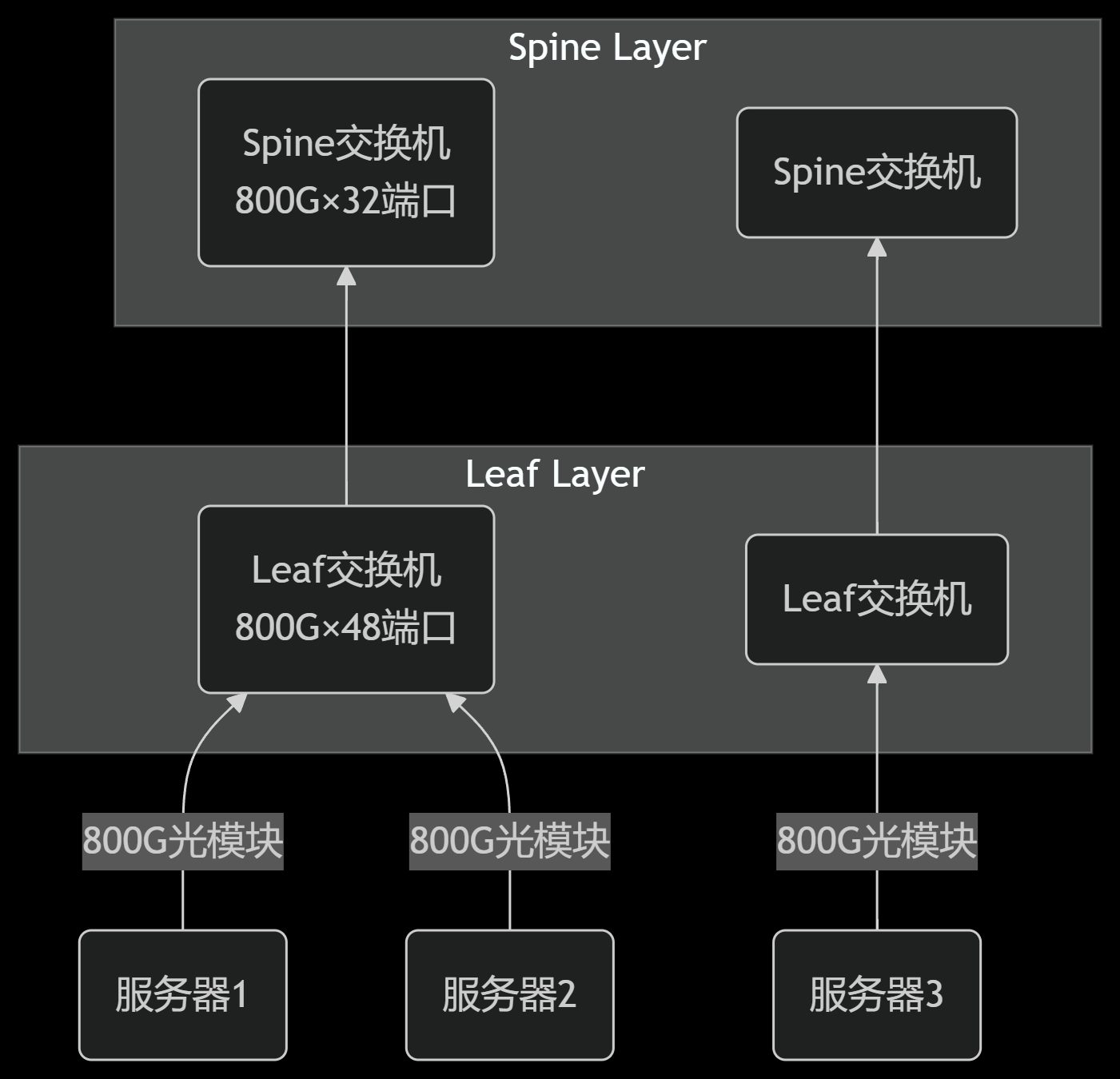

物理拓扑图(含光模块部署)

关键部件描述:

Spine交换机:完全互联的主干,必须支持800G OSFP光模块和ECMP

叶子交换机:每个交换机通过双光模块连接到两个主干交换机,以避免单点故障

服务器连接:使用200G有源光缆(AOC)直接连接到Leaf

三、双链路核心技术原理

1. 同构和异构链路适配

双链路可以使用“同构链路”(两条相同类型的链路,例如都是 InfiniBand HDR)或“异构链路”(例如一条 InfiniBand 用于低延迟通信,一条以太网用于大容量数据传输)

2.动态链接资源分配

无缝切换机制:采用“主备模式”或“负载均衡+动态调整”:

主备模式:正常情况下,主链路承载主要流量,备用链路仅传输心跳包;发生故障时,备用链路以微秒级速度接管所有流量,确保数据不丢失。

负载均衡模式:两条链路同时工作,故障后存活的链路自动接管所有流量(协议层需要支持流量重分配,避免拥塞)。

FIBERTOP 光模块源头厂家直销 | 72小时发货 | 智能计算中心解决方案 | 可定制